افزایش سرعت ایندکس شدن صفحات (مهم)

- موتور های جستجو

- 5868 بازدید

- 28 نظر

در جومینا همواره سعی میکنم مطالب ناب و ارزشمندی را منتشر کنم که در جای دیگری منتشر نشده باشد و همچنین موضوعات مهمی را عنوان کنیم که از سطح آموزش های دست چندمی که بیشتر در سایت ها یافت میشود چند قدم جلوتر باشد در آموزش امروز نکته مهم و ارزشمندی را برای شما مطرح میکنم که سابقه ان باز هم بر میگردد به حدود 6 تا 8 ماه پیش اگر زود تر این آموزش را قرار ندادم تنها به دلیل مشغله فراوانی است که دارم امیدوارم لذت ببرید

قبل از هر چیز موضوع صحبت ما امروز مربوط به فایلی به نام robots.txt میباشد که با هسته جوملای خام در برروی روت سایت شما قرار میگیرد همه سایت ها اللخصوص جوملایی دارای این فایل هستند . کار این فایل چیست؟

این فایل به ربات گوگل میگوید که میتواند به چه پوشه هایی دسترسی داشته باشد .اجازه دهید ابتدا نگاهی به داخل این فایل بیاندازیم

User-agent: *

Disallow: /administrator/

Disallow: /bin/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /layouts/

Disallow: /libraries/

Disallow: /logs/

Disallow: /modules/

Disallow: /plugins/

Disallow: /tmp/

حال اجازه دهید ببینیم معنی کد های نوشته شده در این فایل چیست؟

User-agent: *

به معنای آن است که از هر مرورگری که ربات وارد میشود و یا از هر موتور جستجویی که وارد میشود

Disallow: /administrator/

به معنای آن است که به پوشه administrator دسترسی نداشته باشد در حقیقت مطلب و یا فایلی از ان را ثبت نکند

تا بداین جای کار که ساده است حال ببینیم که چرا به ربات ها میگوییم به یک پوشه دسترسی نداشته باشد ؟

دلیل ان این است ممکن است شما فایلی در درون پوشه داشته باشید که دارای مشکل امنیتی باشد اگر این فایل در موتور جستجو ثبت شود هکر ها میتوانند با جستجوی نام آن متوجه شوند سایت شما از ان فایل استفاده میکند . اجازه دهید کمی مطلب را بیشتر بشکافیم فرض کنید شما در حال استفاده از یک کامپوننت به نام gallery هستید وقتی لینک های سایت خود را سئو مینمایید با جستجو com_gallery در قسمت جستجو گوگل مشخص نمیشود که شما در حال استفاده از این کامپوننت هستید . حال فرض کنید این کامپوننت دارای مشکل امنیتی باشد هکر تنها کافی است در گوگل سرچ نماید com_galley و بدلیل انکه از سایت شما لینکی با عنوان این پوشه ثبت شده است متوجه میشود شما در حال استفاده از این کامپوننت میباشید به همین سادگی ! لذا ما در robots.txt دسترسی پوشه هایی که ممکن است با ثبت ان در موتورهای جستجو مشخص شود از چه افزونه هایی استفاده میکنیم میبندیم .

اما این موضوع یک مشکل اساسی ایجاد میکند

این مشکل چیست و چگونه باید ان را حل نمود ؟ گوگل از حدود دو سال پیش اقدام به رندر نمودن صفحات وب مینماید . رندر شدن صفحات به معنای ان است که گوگل هم کد های css و هم کد های javascript سایت شما را بررسی میکند اما چرا ؟ به دلیل انکه اولا بررسی میکند که سایت شما به چه میزان از نظر جذابیت برای بازدید کنندگان مناسب است ، دوما بررسی میکند که در کدهای سایت از نظر امنیتی مشکلی وجود نداشته باشد و همچنین بررسی میکند که آیا سایت با انواع گجت ها مثل تلفن همراه و تبلت قابل رویت هست یا خیر . در همین رابطه دو مقاله مهم در وبلاگ رسمی گوگل منتشر شده است که البته اینوب لاگ نمیدانم به چه دلیل اما در ایران فیلتر است اما آدرس های این دو مقاله را به صورت تصویر برای شما قرار میدهم

این بدین معنا است که دیگر موتورهای جستجو تنها به محتوای صفحات شما نگاه نمیکنند بلکه کل یک صفحه را بررسی میکنند حال شما در فایل robots.txt در حال بستن کلیه css ها و جاوا اسکریپت ها هستید که این امر بر روی رتبه سایت شما و همچنین سرعت ایندکس شدن صفحاتتان تاثیر مخربی خواهد گذاشت.

اجازه دهید با مثال مطلب را پی بگیریم در وب سایت webmastertools به آدرس

https://www.google.com/webmasters/tools/home?hl=en

بخشی وجود دارد به نام fetch as google این بخش به شما کمک میکند تا متوجه شوید که آیا آدرس صفحات شما برای گوگل قابل رویت هست و یا خیر و همچنین ایا ربات های گوگل به سایت شما دسترسی دارند و یا خیر . گرچه استفاده های رندانه دیگری هم میتوان از این قسمت نمود که اگر عمری بود در مقاله ای دیگر در باره ان بیشتر توضیح میدهم

حال فرض کنید فایل پیش فرض robots.txt فعال میباشد

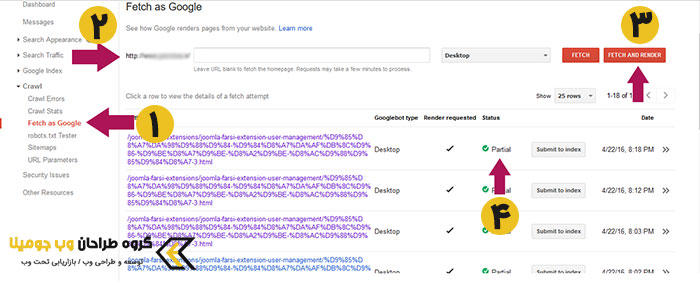

من آدرس یک صفحه از سایت جومینا را fetch میکنم لطفا به تصویر زیر توجه فرمایید

1- بر روی fetch as google کلیک میکنم

2- آدری صفحه ای که میخواهم بررسی شود را از بعد از دامنه (مهم) وارد میکنم

3- بر روی fetch and render کلیک میکنم

4- صبر میکنم تا نتیجه را مشاهده کنم

در این قسمت میبینید که زیر ستون Status نوشته شده Partial

Partial به نا تمام میباشد یعنی وضعیت رندر شدن صفحات شما ناتمام میماند . بدون شک اگر موارد این اموزش را اجرا ننمایید برای شما هم همین وضعیت پیش خواهد آمد که مطابق با الگریتم های گوگل به ایندکس شما صفحات شما صدمه میزند و رتبه سایت شما را کاهش میدهد .

راه حل این مشکل چیست ؟

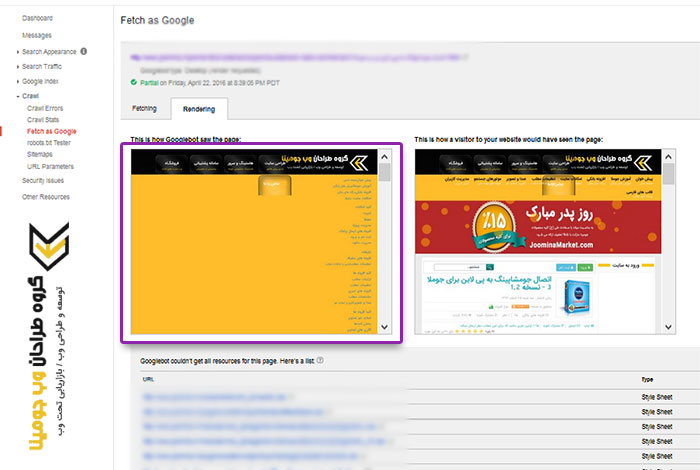

بر روی کلمه partial کلیک کنید با صفحه ای مطابق زیر روبرو میشوید

تصویر سمت چپ آن چیزی است که گوگل از صفحه وب سایت شما درک نموده و تصویر سمت راست آن چیزی است که بازدید کننده از سایت شما مشاهده میکند در صورتی که میباشدهر دو یکی باشددلیل این امر ان است که در فایل robots,txt شما دسترسی به پوشه های متعددی را بسته اید از جمله به عنوان مثال من دسترسی به پوشه modules را بسته ام اما فایل های css ماژول منو من در پوشه ماژول قرار دارد برای همین ربات گوگل نمیتواند به این فایل دسترسی داشته باشد . در زیر این دو تصویر یک سری لینک نمایش میدهد که مطابق ان گوگل به شما میگوید که به چه فایل های لازمی دسترسی ندارد مثل همان فایل css ماژول منو که همانطور که در تصویر مشاهده میکنید بهم ریخته است

حال باید چکار کنیم؟

شما میتوانید در فایل robots.txt دسترسی به یک پوشه را ببندید اما دسترسی به ساب فلدر آن را باز نمایید و دسترسی به یک فایل خاص را باز کنید

برای باز عنوان دسترسی از دستور Allow: استفاده میکنیم . به عنوان مثال به کد های زیر توجه کنید

Disallow: /modules/

Allow: /modules/mod_joomina/css

Allow: /modules/mod_joomina/js/jquery.js

در خط اول من دسترسی ربات را به کل پوشه module بسته ام اما در خط دوم به ربات گفته ام میتوانید به پوشه css در ماژول joomina دسترسی داشته باشی و در خط سوم به ربات گوگل میگویم میتوانید به فایل jquery.js در پوشه js در ماژول joomina دسترسی داشته باشید یعنی هم میتوانیم دسترسی به کل پوشه را بدهیم و هم میتوانیم از یک پوشه تنها به یک فایل دسترسی بدهیم

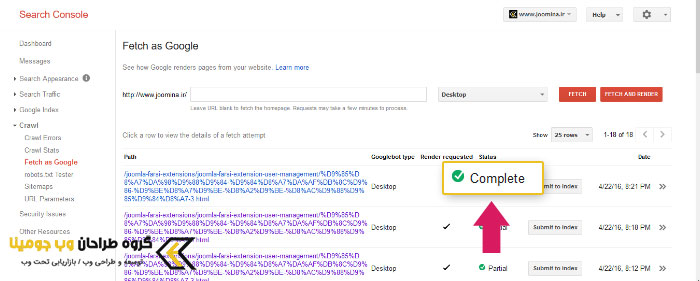

همانطور که قبلا هم عنوان شد در زیر تصویر لینک هایی که ربات گوکل بدان دسترسی ندارد را داریم میتوانیم تک به تک لینک ها را با روش بالا در فایل robots.txt . توجه داشته باشید شما نباید به Disallow دست بزنید بلکه تنها برای آن فایل هایی که نیاز است در زیر دستورات پیش فرض ربات از دستور Allow: استفاده نمایید .. پس از انجام این کار دوباره مراحل fetch نمودن را انجام دهید و چند بار این کار را تکرار نمایید تا مطمئن شوید گوگل به تمامی فایل های css و javascript مورد نیاز برای خواندن صفحات وب سایت شما دسترسی دارد .. اگر این کار را درست انجام دهید میباید با تصویری مطابق زیر روبرو شوید

با روبرو شدن با این کلمه (Complete) کار شما تمام است

چون میدانم ممکن است برای خیلی ها سئوال پیش بیاید که این کار به امنیت ما صدمه ای نمیزند ؟ پیشاپیش پاسخ میدهم خیر با فایل css و جاوا اسکریپت کسی کار نمیتواند انجام دهد

در این مقاله به یکی دیگر از مشکلات سئو زمانی که شما در حال کار با سیستم های مدیریت محتوا هستید پرداختیم و روش حل ان هم گفتیم صمیمانه به کاری که داریم عشق میورزیم و امیدواریم شما نیز بتوانید لذت طراحی سایت را با ما تجربه کنید .

ارادتمند

امیررضا تهرانی

- برچسب ها

- بهینه سازی

- گوگل

- موتورهای جستجو

مطالب مرتبط :

نظرات (28)

-

با عرض سلام و خسته نباشید

مهندس تهرانی فوق العاده بود این آموزش واقعا جای تشکر داره

فقط یک نکته پیش اومد که گفتم مطرح کنم شاید راه حلی براش داشته باشین

من چند تا صفحه رو تست کردم و دقیقا همین مشکل را داشت

و وقتی لینک اون چیزی رو که گوگل به خاطر عدم دسترسی بهش خطا میداد این بود که

من از یک اسکریپت آمار از سایت histats.com استفاده میکردم در سایتم

و گوگل خطاش این بود که به فایل های js این اسکریپت در اون سایت دسترسی نداره!

برای این مشکل راه حلی هست یا اینکه واقعا نمیشه از اسکریپت های خارج از سایت استفاده کرد؟!

بازهم از زحماتتون ممنونم

یاعلی -

درود

امیدوارم بتونم کمکی بکنم

یک راه ساده تر:

در فایل robots.txt فقط قطعه کد زیر رو قرار بدین اینطوری دیگه نیاز به هیچ کار دیگه ای نیست

#Googlebot

User-agent: Googlebot

Allow: *.css

Allow: *.js

در پناه ایزد یا حق

-

سلام

برای یکی از سایت هایم اینکارو کردم اما توی توضیحات همیشه خط آخر یه لینک تکراری میده:

http://fonts.googleapis.com/css?family=.

تا اینو درست نکنم complate نمیده. چیکار کنم؟ -

سلام مهندس جان

بسیار مطلب آموزنده ای گذاشتید . ممنون از شما من این مورد را نمی دونستم اما انجام دادن واقعا آمار بازدید از سایتم بیشتر شده ... -

سلام

اینکارو انجام دادم

الان به این آدرس برید لطفا ببینید چه شکلی شده؟این به مشکل بر نمیخوره؟امنیتش خوب نیست اینجوری که!!

http://www.namincarpet.com/robots.txt -

سلام

لازم نیست دونه دونه برای همه فایل های سایت انجام بدید

برای یک فولدر انجام بدید تا برای همه فایل های درونش انجام بشه

ضمن اینکه امنیت سایت تون با این کار به خطر نخواهد افتاد

-

سلام علیکم

جناب آقای مهندس تهرانی وقت شما بخیر و نیکی

احتراما؛ضمن تشکر از مطلب بسیار خوب شما

من یه مشکلی دارم ممنونم راهنمایی بفرمایید. این آدرس ساب فولدر ها رو نمیتونم درست پیدا کنم . چند بار امتحان کردم ولی صفحه Partial رو هنوز نشون میده .

با تشکر از زحمات شما -

وقتی روی partial کلیک میکنید دقیقا زیر جعبه ای که دو تصویر از وب سایت شما انداخته فلدر ها را نوشته

-

با سلام

عذر میخوام آقای مهندس من دقیقا همین لینک هایی که زیر عکس ها نشون داده رو دستور Allow: رو استفاده کردم ولی باز یک سری لینک رو هنوز نشون میده .... در صورت امکان اگه محبت بفرمایید لینک های خارجی و گوگل مپ رو با مثال توضیح دهید ممنونم .

در پناه الله متعال باشید. -

-

باعرض سلام خدمت مهندس تهرانی عزیز

از آموزش های خوبتان ممنون و سپاسگزارم/عالی بود|جناب مهندس قبلا جومینا برای جوملا 2.5 ماژولی منتشر کرده بود که مطالب جوملا رو پینگ میکرد میشه لطف کنید اون ماژول کاربردی و عالی رو برای جوملا 3 هم منتشر کنید/ممنون از زحمات شما -

درود ، اتفاقا همین حالا خودم دارم در سایت ازش استفاده میکنم میخواستم یکم بهبودش بدم و چند تا پینگ دیگه غیر از pingo-matic بهش اضافه کنم بعد منتشر کنم . اما خیلی سرم شلوغه در اولین فرصت حتما

-

سلام

شمن تشکر از زحمات شما و راهنمایی های عالی شما،

لطفا بفرمایید برای فونت ها و لینک های خارجی چه می توان کرد؟ -

با سلام ، اتفاقا سئوال خوبی است برای اون ها هم از Allow: استفاده کنید یعنی همان لینکی که ایراد گرفته را جلیوی allow قرار دهید

-

با سلام

خدا قوت به شما جومینایی ها

من مطابق آموزش شما عمل کردم چند تا حسن داشت اونم به صورت چشمگیر.

1-با لارفتم سرعت بارگذاری کل اجزای صفحه

2-بالا رفتن تعداد بازدید

3-پایین آمدن رتبه الکس

باسپاس -

سلام آقای تهرانی و ممنون از این مقاله عالیتون

سوالی داشتم و اینکه :

در یه سایت فروشگاهی که در تعداد از صفحات آن مقدار زیادی از تصاویر محصولات وجود داره که وقتی fetch می کنم دسترسی به این تصاویر رو نداره آیا باید به تک تک تصاویر دسترسی بدم و یا اینکه روش دیگه ای برای اینکار وجود داره صرفه جویی در وقت بشه؟

با تشکر -

سلام و خسته نباشید

بعد از fetch و complete شدن پیغامی در جلوی آن با عنوان submit to index وجود داره آیا باید روی ان کلیک کنیم یا نه؟ -

بلــــــه کلیک کنید ماهیانه تا 500 durectlink و 10 crawl on link میتونید داشته باشید

-

با سلام. واقعا ممنون بابت مطالب مفید ، بکر و مهمتون. خواهشا مطالب بیشتری از این دست قرار بدید. با اینکه مبتدی هستم ولی نوع بیانتون باعث انتقال حداکثری مطلب میشه . موفق باشین

-

درود بر شما من حدود چند ماه پیش که گوگل الگوریتم mobile-friendly رو فعال کرد این کار رو انجام دادم و نکته جالب اون هم ایندکس شدن صفحاتم حتی پس از 10 ثانیه است..

از دوستان جوملایی خواهش می کنم به این موارد اهمیت بدید

این اموزش ها فوق العاده ناب هستند و ارزش کار تیم جومینا هم به همین نو اوری ها در افزونه و مطالب اموزشی ست

سربلند باشید

من فایل جلسه اول رو دیدم و عالی بود.

میخوام در این دوره شرکت کنم که از ادامه دوره ...

این دوره کاملا رایگان بود و قسمت های بعدی هم در سایت منتشر نمیشود

لینک دانلود کجاست ؟